Für KI ist Platz auf kleinstem Raum

AI, KI, ML - diese Buchstaben stehen für eine neue Ära, die mit Künstlicher Intelligenz und Maschinellem Lernen in der Entwicklung mikroelektronischer Systeme neue Design- und Anwendungsmöglichkeiten schafft und jetzt auch für und auf eingebetteten Systemen. Auf der embedded world 2023 vom 14. bis 16. März in Nürnberg zeigen Expertinnen und Experten für KI/ML-Technologien des Fraunhofer-Instituts für Integrierte Schaltungen IIS in Halle 4-422 Edge AI-Entwicklungen: von der Integration Künstlicher Intelligenz in Hardware bis hin zu neuen Umsetzungswegen KI-zentrierten Hardware-Designs.

Optimale Ausnutzung des Entwurfsraums

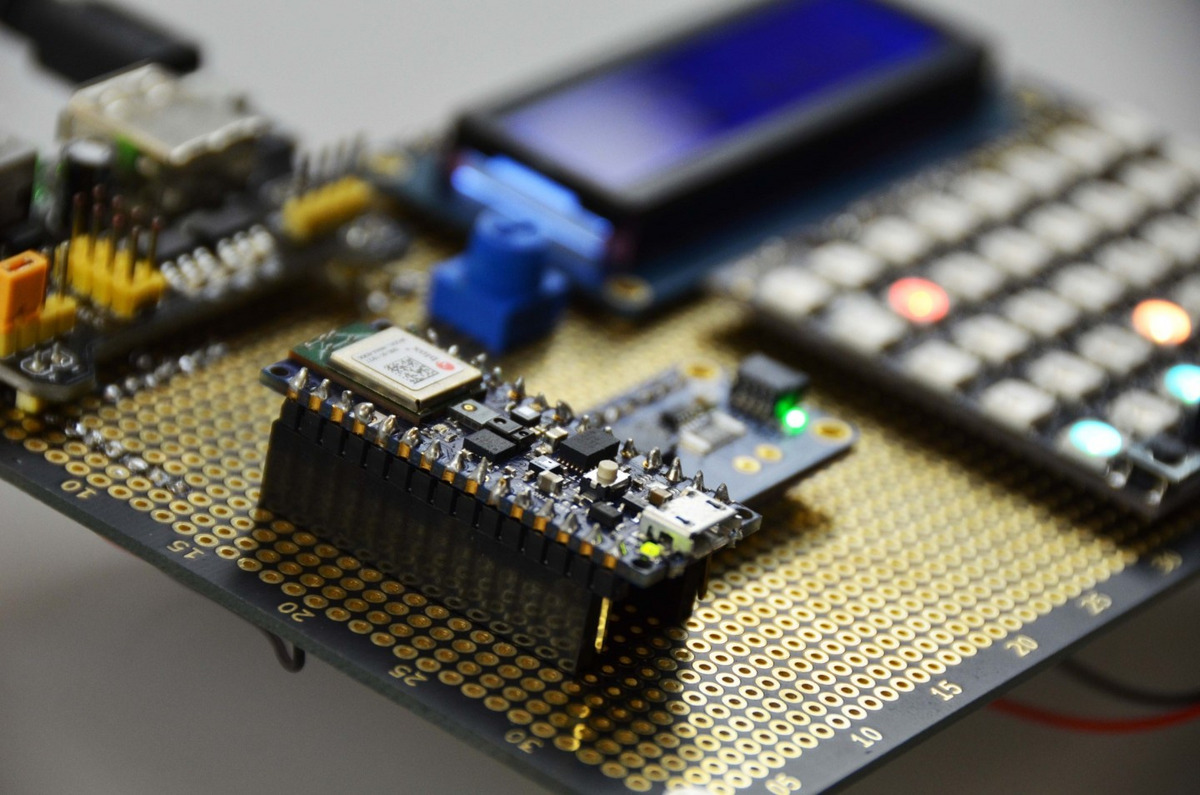

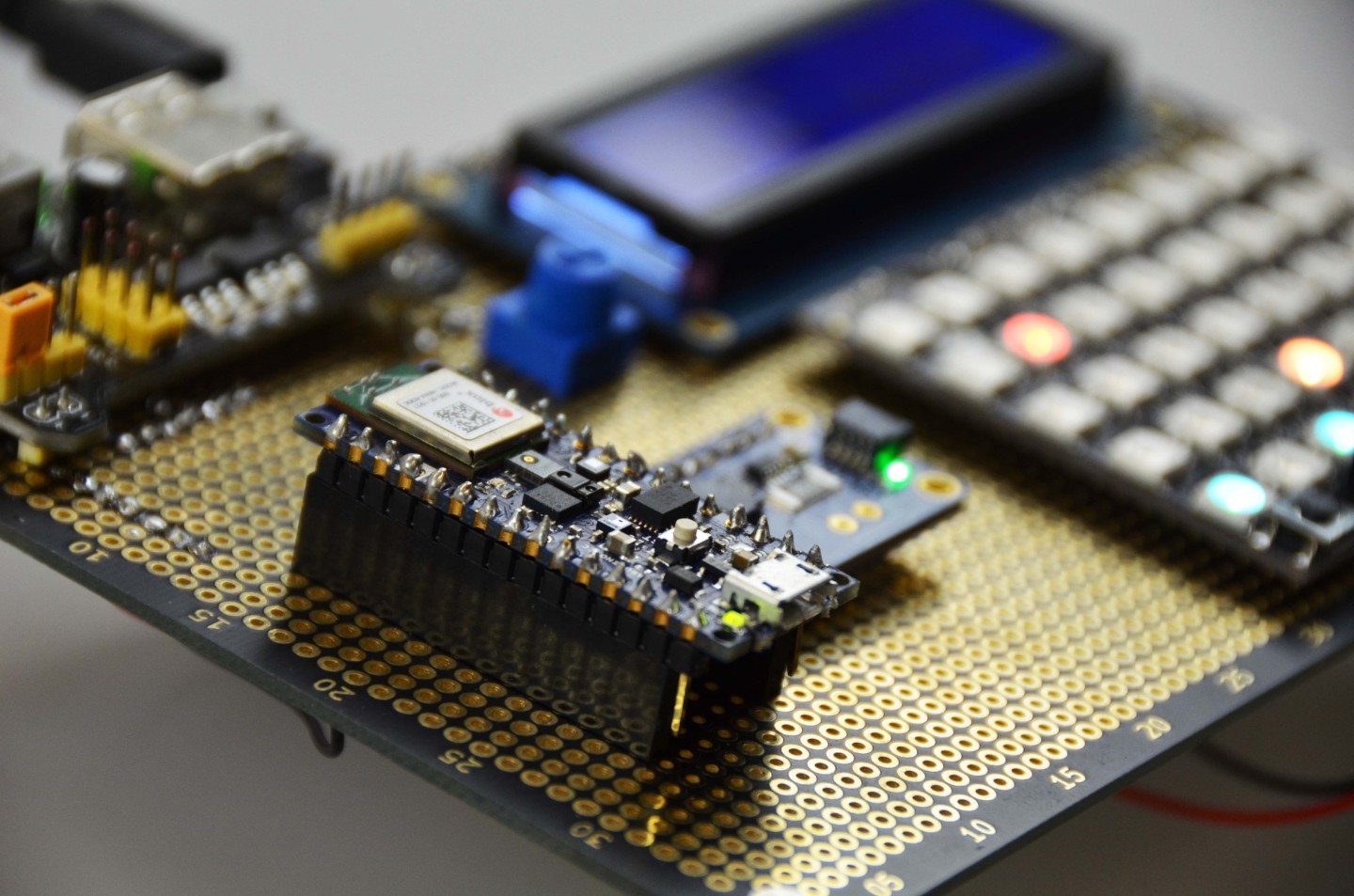

Der Platz für umfangreiche Analysen und Vorverarbeitungen in bestehender Hardware und eingebetteten Systemen ist meist äußerst begrenzt. Die Schlüsselfrage ist also, wie man unter diesen Einschränkungen dennoch leistungsfähige KI-/ML-Anwendungen implementieren kann. Die Lösung ist eine so genannte multikriterielle Entwurfsraumexploration, die sowohl der begrenzten Hardware als auch der Anwendung gerecht wird und hier die optimalen Möglichkeiten auslotet. Zu diesem Zweck entwickeln die Expertinnen und Experten des Fraunhofer-Instituts für Integrierte Schaltungen IIS automatische Explorations- und Optimierungstechniken. Dazu verwenden sie so genanntes Reinforcement Learning und genetische Algorithmen, um schnell eine Vielzahl von Lösungen untersuchen zu können, ebenso wie klassische maschinelle Lern-Pipelines und effizient komprimierte Deep-Learning-Modelle.

»Mit embeddif.[ai] bietet das Fraunhofer IIS eine schnelle Entwicklung von KI-Lösungen für verschiedene eingebettete Hardwaresysteme«, erklärt Nicolas Witt, Gruppenleiter Maschinelles Lernen & Validierung. »Unternehmen können KI-Anwendungen energieeffizient vor Ort betreiben, unabhängig von einem Cloud-Server. Diese Vorteile ermöglichen es, Künstliche Intelligenz auf kleinstem Raum für ihre Anwendungen zu nutzen.«

So nah wie möglich am Geschehen

Gerade bei eingebetteten Sensoren und Systemen ist der Einsatz von KI und ML ein kaum zu überbietendes Plus, um den Effizienzeffekt durch schnelle Datenanalyse möglichst nah an der Datenerfassung und eventueller Aktorik-Technologie zu gewährleisten. Dazu kommen kurze Wege und damit geringe Verzögerungen, keine zusätzliche Analyse-Hardware oder komplexe Cloud-Anbindungen, die zu Lasten von Energieverbrauch, Nachhaltigkeit und Effizienz gehen. Bei der Auswahl und Anwendung von KI-Pipelines setzen die Wissenschaftlerinnen und Wissenschaftler auf Methoden, die möglichst schnell und energieeffizient direkt in handelsübliche Mikrocontroller, FPGAs oder Grafikkarten implementiert werden und den begrenzten Platz optimal ausnutzen. Auf diese Weise lässt sich KI durch maßgeschneiderte Anpassung in bestehende Hardware bis hin zum Sensor, der Kamera oder angeschlossenen Embedded-Modulen integrieren. Das Fraunhofer IIS bietet so genannte »Joint Labs« zur Realisierung von KI-Anwendungen und einen umfassenden Know-how-Transfer an. Darüber hinaus können eingebettete KI-Entwicklungs-Frameworks als Starthilfe für Systemprogrammierer in Unternehmen zur Verfügung gestellt werden, die für deren Anwendungen angepasst werden können. Zusätzlich bieten die Fraunhofer IIS-Expertinnen und -Experten Schulung und Support für die Umsetzung an.

Wenn KI direkt in den Chip einzieht

Neben der Entwicklung und Anpassung von KI-Methoden für bestehende Hardware gehen die Wissenschaftlerinnen und Wissenschaftler des Fraunhofer IIS einen Schritt weiter, um KI an den Rand der Anwendung - den so genannten Edge - bzw. in ein geeignetes Chipdesign zu bringen. Sie arbeiten auf dem Gebiet des neuromorphen Computings und entwickeln Chips mit einer Architektur, die auf biologischen neuronalen Netzen basiert. Ein Beispiel dafür sind Spiking Neural Networks (SNNs). »Im Grunde funktionieren SNNs ähnlich wie ein klassisches neuronales Netz. Sie senden Informationen in Form von kurzen Impulsen«, sagt Johannes Leugering, Chief Scientist für Embedded AI am Fraunhofer IIS. »Der Trick besteht darin, nur gelegentlich eine sehr kleine Menge an Informationen zu senden, nämlich genau dann, wenn etwas Interessantes passiert ist. So reduzieren wir die Datenmenge und damit auch den Energieverbrauch.« Das Fraunhofer IIS arbeitet sowohl an Spiking- als auch an Convolutional Neural Networks in qualifizierten Mixed-Signal-CMOS-Technologien, die skalierbar und für eine Vielzahl von Anwendungen konfigurierbar sind. Die notwendigen Software-Werkzeuge zum Training der Netze sowie die Übertragung der Netze auf die Hardware werden im Tandem entwickelt. Die resultierenden Lösungen bieten mehr Parallelverarbeitung und weniger On-Chip-Datentransfer als vergleichbare Systeme auf Basis der von-Neumann-Architektur.

Messe embedded world 2023 vom 14. bis 16. März in Nürnberg

Mit embeddif.[ai] können Unternehmen KI Anwendungen energieffizient und unabhängig von einem Cloud-Server betreiben. © Fraunhofer IIS